Spark大数据平台开发

[关键词:Spark,大数据] [热度 ]| 提示:此毕业设计论文完整版包含【论文】 作品编号:rjgc0392,word全文:32页,合计:10000字 |

本文介绍了Spark的基本组成部分,生态系统,部署模式,分析了Spark的编程模型,实现了Spark on YARN集群部署,并且设计实现了k-means算法。

本文的主要工作是:

(1)第一步:前期准备。熟悉Spark的基础知识,例如:生态系统,体系结构等等;熟悉Linux操作系统的基本常用命令,例如:解压,配置环境命令等;熟悉Hadoop YARN背景知识,例如:搭建Spark on YARN的具体操作步骤。

(2)第二步:构建Spark运行环境。本文采用的是Spark on YARN部署集群的方式来搭建本文的实验测试环境的,集群的主要架构由一个master节点和两个slave节点组成的,集群统一安装了Linux操作系统(ubuntu)。

(3)第三步:构建Spark开发环境。本文安装了IDEA用于进行使用Scala语言的Spark程序的开发和测试。本文在IDEA中进行程序编写,编写后生成可以在Spark集训上运行的JAR包。启动Spark集群计算出最终结果

(4)第四步:算法设计实现。本文实现k-means算法是通过装载数据集,将数据集聚类然后迭代的方式形成数据模型,使用数据模型测试单点数据,返回最终测试结果。

论文内容的组织结构

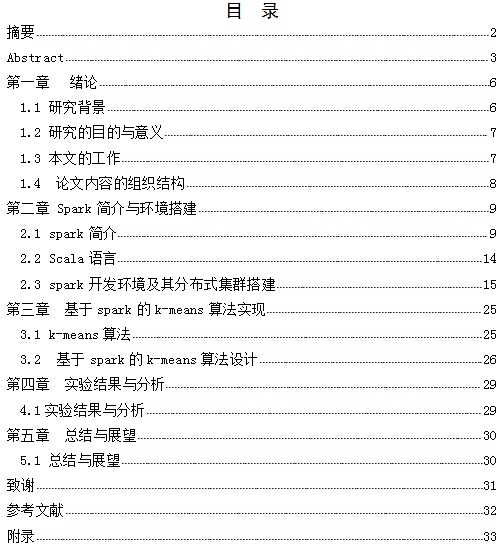

本文全文由五部分组成:

第一章为绪论部分。简要的介绍了本文的研究背景和意义,以及主要的研究内容。

第二章为Spark简介和Spark运行环境和集群部署。介绍了Spark的生态系统中各个组成部分,阐述了Spark的编程模型RDD的工作原理以及Spark的三种部署模式,详细介绍了Spark运行环境搭建和集群部署的每一个操作步骤。

第三章为k-means算法的实现。介绍了k-means算法原理和本文算法的实现步骤。

第四章为实验结果分析。简要分析了k-means算法的执行结果。

第五章为总结与展望。主要是对本文总结以及对本论题的研究展望以及对给予帮助的老师和各位朋友表示感谢

最后是参考文件和附录部分。

本文的主要工作是:

(1)第一步:前期准备。熟悉Spark的基础知识,例如:生态系统,体系结构等等;熟悉Linux操作系统的基本常用命令,例如:解压,配置环境命令等;熟悉Hadoop YARN背景知识,例如:搭建Spark on YARN的具体操作步骤。

(2)第二步:构建Spark运行环境。本文采用的是Spark on YARN部署集群的方式来搭建本文的实验测试环境的,集群的主要架构由一个master节点和两个slave节点组成的,集群统一安装了Linux操作系统(ubuntu)。

(3)第三步:构建Spark开发环境。本文安装了IDEA用于进行使用Scala语言的Spark程序的开发和测试。本文在IDEA中进行程序编写,编写后生成可以在Spark集训上运行的JAR包。启动Spark集群计算出最终结果

(4)第四步:算法设计实现。本文实现k-means算法是通过装载数据集,将数据集聚类然后迭代的方式形成数据模型,使用数据模型测试单点数据,返回最终测试结果。

| 提示:此毕业设计论文完整版包含【论文】 作品编号:rjgc0392,word全文:32页,合计:10000字 |

本软件工程毕业设计论文作品由 毕业论文设计参考 [http://www.qflunwen.com] 征集整理——Spark大数据平台开发(论文)!

当前位置:

当前位置: